藍鯨新聞4月17日訊(記者 朱俊熹)當地時間4月16日,OpenAI發布最新的推理模型o3和o4-mini。OpenAI表示,這是其“迄今為止發布的最智能的模型”,在智能性和實用性方面設定了全新標準。

據OpenAI介紹,o3是其最強大的推理模型,在數學、編碼、科學、視覺感知等領域的表現都超過了前代o1、o3-mini模型。“它非常適合處理需要多方面分析、答案可能不是立即顯而易見的復雜查詢。”o4-mini則是一款經過優化的小型模型,旨在提供快速、經濟高效的推理。

在o3開發過程中,OpenAI稱發現大規模強化學習呈現出與GPT系列預訓練相同的趨勢,即“計算量越大,性能越好”。OpenAI在訓練計算量和推理過程中的思考方面都提升了一個數量級,看到了明顯的性能提升。通過強化學習,OpenAI還訓練兩個新模型使用工具。

最新的推理模型o3和o4-mini能夠組合使用ChatGPT中的所有工具,包括網頁搜索、圖像生成、使用Python分析數據等。在OpenAI提供的示例中,當用戶詢問電池技術的突破對電動汽車的影響時,o1模型在推理5秒后給出了文字、代碼片段為主的回復,而o3模型經過40秒的推理時間,多次使用搜索功能,除文字外還能直接生成圖像和圖表。

圖片來源:OpenAI

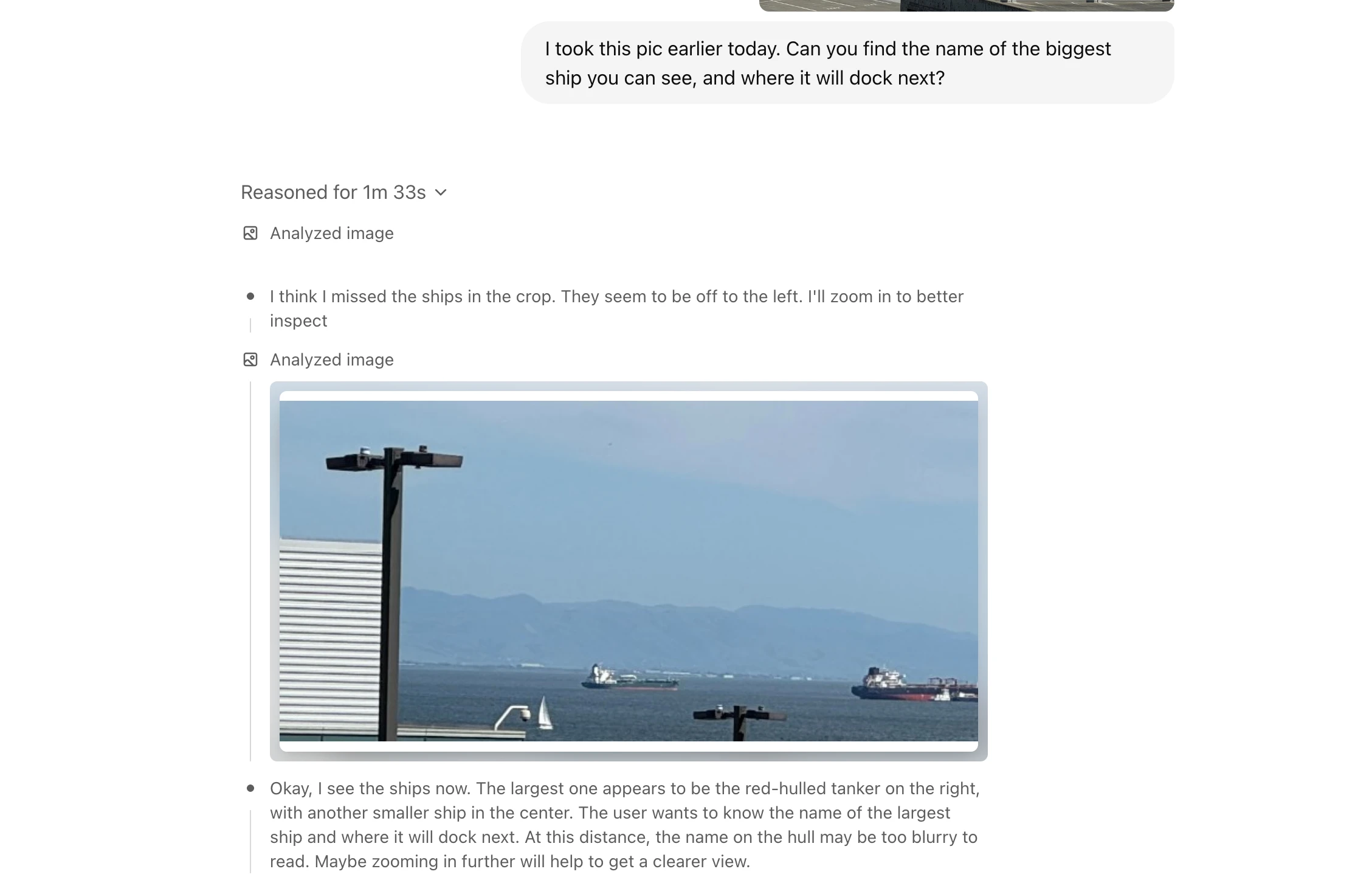

相較于前代推理模型,新模型在視覺推理方面也取得突破。o3和o4-mini不僅可以“看到”圖像,還能夠用圖像來思考,將其整合到思維鏈中。例如,當用戶上傳一張倒著拍的手寫筆記照片時,模型在推理過程中能夠借助工具,對圖像進行縮放、旋轉或裁剪,最終識別出筆記上的手寫內容。

圖片來源:OpenAI

去年9月,OpenAI率先推出推理模型o1,引領了大模型范式的轉變。自那以來,全球許多大模型廠商都發布了自己的推理模型,包括谷歌Gemini 2.5、Grok 3,以及國內的DeepSeek-R1、通義千問QwQ-32B等,對OpenAI形成了追趕。3月底,阿里通義也推出了視覺推理模型QVQ-Max,同樣主打能結合圖片、視頻信息進行分析和推理。

激烈的競爭讓OpenAI對新模型的發布更為迫切。據英國《金融時報》上周報道,OpenAI一直在推動盡早發布o3模型,使得員工和第三方組織僅能在幾天時間內,對模型性能和風險進行安全評估。而2023年發布的GPT-4模型,經過了6個月的評估。OpenAI強調,已對o3、o4-mini兩個模型進行了至今最嚴格的安全壓力測試。

事實上,o3模型原本并不在OpenAI的預期路線圖中。2月中,OpenAI CEO Sam Altman曾在社交平臺X上表示,將不會單獨發布o3模型,而是會將o3的技術集成到下一代GPT-5模型中,預計在幾周或幾個月內推出。Sam Altman曾多次抱怨,算力的限制導致公司不得不推遲新模型的發布。今年3月OpenAI完成400億美元的新融資后,他終于表示“不再受到計算限制”。

OpenAI稱,o3和o4-mini的發布反映了其模型的發展方向:將o系列的推理能力,與GPT系列的對話能力、工具使用能力相融合。“通過統一這些優勢,我們未來的模型將支持無縫、自然的對話,同時進行主動的工具使用和高級問題解決。”